两周前,Facebook宣布了一个Open Compute项目,彻底公开机房和服务器设计。

这件事的背景是,Facebook最近在俄勒冈州的普林维尔(Prineville),建成了一个世界上最先进的节能机房,号称能效提高38%,建造成本降低24%。

根据Facebook公布的资料,以及Robert Scoble的参观记,这个机房有很多有意思的地方。

1.

机房坐落在一片荒原上,距离普林维尔市区大概半个小时车程。这里气候干燥,气温适中(夏季最高温度40度),有利于节能。

2.

机房外部有很多小型的太阳能电板,主要用来为一些附属建筑供电。

3.

整个机房规模很大,长度大概相当于三个沃尔玛超市。

4.

机房的全景。

5.

机房的正门。

6.

进门后,有一些当地的历史介绍。

7.

接待室。

8.

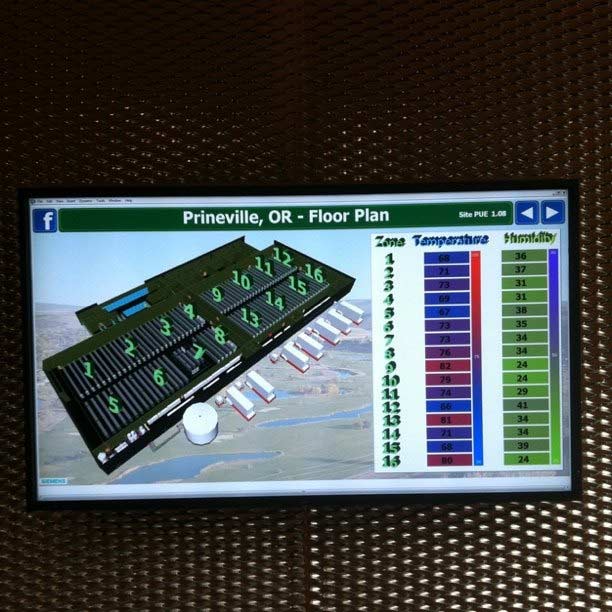

墙上的液晶显示屏,实时显示各部分的温度和湿度。

9.

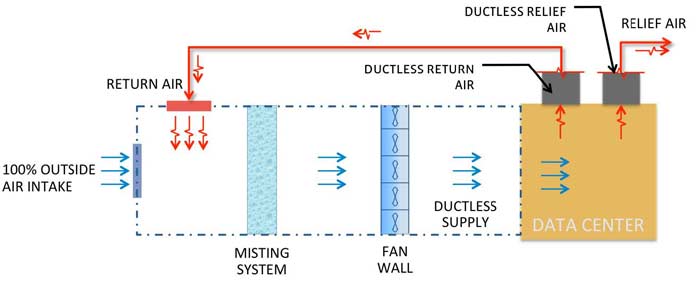

机房的节能设计,主要体现在三个方面:不使用空调(自然风冷却),简化的供电设计,低耗电的服务器设计。

10.

上图是机房空气循环系统的设计示意图。从图中可见,外部空气进入机房,一共要经过三道冷却步骤。

11.

第一道步骤,是大量铜管组成的热交换器,使得空气热量尽快散发。

12.

走近一点看铜管。

13.

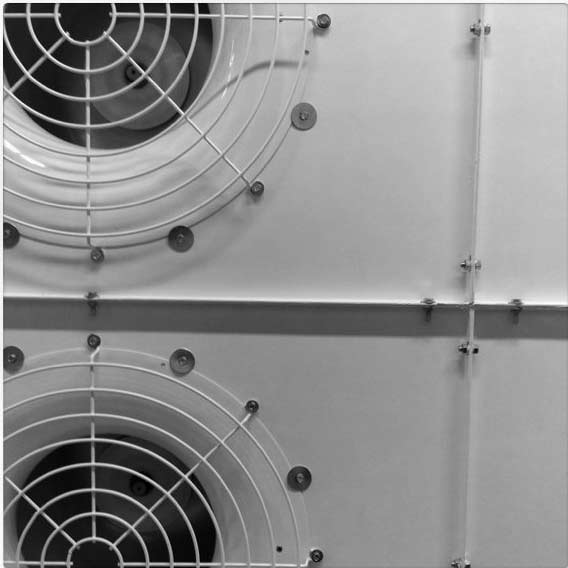

第二道步骤,是使用风扇墙为空气降温。

14.

风扇墙的侧面照。

15.

除了大型风扇,还装有许多小型风扇。

16.

小型风扇的细部。

17.

第三道步骤是喷雾,喷出细小的水珠为空气降温。

18.

走近看喷雾墙。

19.

喷嘴的特写。

20.

完成这三道步骤之后,热空气就变成了冷空气,可以输入机房降温了。整个机房大厅,分为左右两半。

21.

服务器柜都装上了蓝色Led灯。

22.

服务器柜之间的走道。

23.

服务器柜中间的那个蓝色柜子,是48V的不间断电源UPS。

24.

每个柜子放30台服务器,每三个柜子为一组,即每组90台服务器。

25.

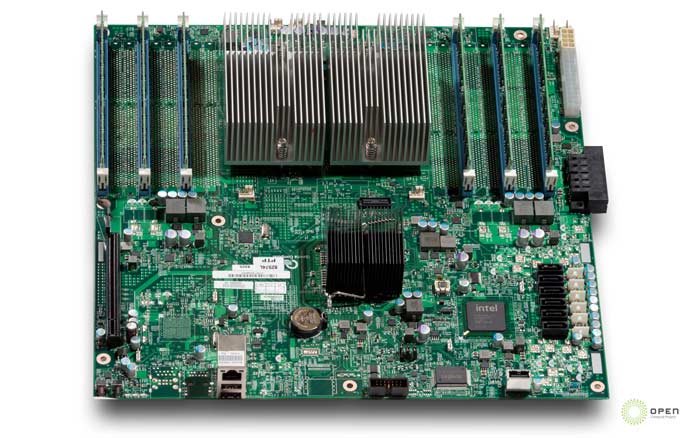

服务器机箱是Facebook自行设计的,比普通机箱大,不含螺丝和尖角,很容易更换里面的元件。

26.

使用两种主板,一种是两颗AMD Opteron 6100 CPU,外加24根内存插槽。

27.

另一种是两颗Intel Xeon 5500(或5600)CPU,外加18根内存插槽。除了必需的元件以外,主板的其他部分都做到最简,减少成本和能耗。

28.

机箱电源是一个450W的交直流转换器,输出12.5V的直流电。

29.

机房的工作间。

30.

另一间工作间。

31.

杂物间。

32.

机房大厅外的走廊。

33.

吃饭的地方。

34.

供员工放松的电子游戏间。

(完)

猪头四 说:

每次阮哥的图片总是那么详细。哪里弄的呀。55

2011年4月18日 14:52 | # | 引用

慵懒人 说:

感觉有点监狱的味道。。。原来运行一个超大型的网站需要这么多服务器呀!!!

2011年4月18日 15:52 | # | 引用

tinyfool 说:

看上去很不错,不过基于排风的方案会不会有很多灰尘,不知道喷水的部分是不是也有防尘这个目的

2011年4月18日 16:16 | # | 引用

tumutanzi 说:

开眼界了。

2011年4月18日 16:41 | # | 引用

吴鹏 说:

确实不错!机房真整洁。

2011年4月18日 17:00 | # | 引用

wzz 说:

我突然想:把机房建在江河湖泊里会不会更节能 有谁已经尝试过了吗

2011年4月18日 17:03 | # | 引用

z 说:

我们的信息就在那里么

黑客帝国啊

2011年4月18日 17:14 | # | 引用

soku 说:

好整洁 很有规划

2011年4月18日 17:55 | # | 引用

不纯粹文人 说:

真气派

很喜欢游戏间

2011年4月18日 19:02 | # | 引用

孙伊卓 说:

很符合国外机房的建设方式.

2011年4月18日 20:37 | # | 引用

CIAO 说:

GOOGLE的信息中心一般都是依水而建,便于降温

2011年4月18日 21:19 | # | 引用

zc 说:

经过这三部降温后,能耗恐怕比空调低不了多少了吧

2011年4月18日 21:37 | # | 引用

工 说:

其实没啥难做的。宣传罢了。以前google在吹嘘,现在论到facebook了,曾经的大哥yahoo倒是没吹过。其他几大网站呢?想想,有谁?mcrosoft?不够格。

2011年4月19日 00:57 | # | 引用

FR 说:

当地的夏季平均气温和最高气温是多少?

2011年4月19日 09:07 | # | 引用

横箫斜吹雨 说:

风扇好容易沾灰尘呀 多了咋清理呢?

2011年4月19日 11:19 | # | 引用

freetao 说:

由open看出到的是facebook对自己技术的自信。

2011年4月19日 11:26 | # | 引用

DJ 说:

的确, 怎么解决灰尘的问题? 像普通的台式机机用两年灰尘都足以遮挡显卡和cpu散热片空隙了, 这种开放环境吹风的不是更容易出现这样的问题吗?

2011年4月19日 12:24 | # | 引用

Josh Zhang 说:

11的图右侧似乎是过滤网

2011年4月19日 13:00 | # | 引用

DZ 说:

喷雾之后,空气中湿度很大,在给机房送风之前用什么工艺去除掉呢?

2011年4月19日 13:40 | # | 引用

rosewalker 说:

不知道和google的比谁更先进?

2011年4月19日 18:22 | # | 引用

elaine爱呢 说:

这么多设备不断工作才成就了这个机房 会不会比直接空调制冷更耗能?

2011年4月19日 19:11 | # | 引用

[email protected] 说:

因为也是正在建机房,虽然够不上三个沃尔玛,也顶的上一个了。

原来这个facebook的机房都只是用两种主机,而且是自定义的,当然可以做成这样的。

如果要求其随便什么主机都能放进去,看他能做成怎么样?

不过的确是希望服务器都用48v直流供电,可以在ups方面节约很多投资,从节能减排和长远投资方面看,48v直流系统必定比380/220v交流系统要好得多。

2011年4月19日 20:45 | # | 引用

cassandra 说:

只能在照片里怀念蓝的这么纯净的天空了

2011年4月20日 10:31 | # | 引用

boson 说:

机房跟《异次元骇客》里的一样~

2011年4月20日 17:12 | # | 引用

longw 说:

貌似顺序弄错了,第一道工序是外面的冷空气和部分的机房排除的热空气混合,喷雾冷却是第二道工序,然后才经过风扇墙。

使用水冷的数据中心也是有的,

2011年4月20日 22:51 | # | 引用

Liu Liu 说:

@DZ, 不去湿,主板和CPU测试过了,可以在60%的湿度环境下正常工作;

@[email protected], 48V是UPS的电源,实际接的应该是440V的交流电直接到机箱的变压器。

2011年4月21日 00:26 | # | 引用

Xu 说:

请问这个从哪儿来的啊? 我对他们怎么做到将这么多服务器集群化管理更有兴趣,不知道是否有这方面的内容? 3q~

2011年4月21日 04:03 | # | 引用

cpeter 说:

24.应该是两个机柜加一个UPS柜,所以每组60台服务器。

2011年4月21日 09:55 | # | 引用

hey 说:

大气!

自信!

2011年4月22日 09:21 | # | 引用

Jason Wu 说:

这机房真不错,去了几个电信机房,都没见几个这么漂亮的

2011年4月22日 11:30 | # | 引用

小石 说:

马克·扎克伯格的步步成长让人敬佩啊 本人对互联网络也蛮感兴趣

2011年4月22日 16:04 | # | 引用

wish 说:

没想到要用这么多服务器呀!

2011年4月23日 01:58 | # | 引用

zengmiao 说:

这些机房散热应该大部分靠蒸发冷却,这种技术要求当地湿度要低,估计这也是建在沙漠的原因,就是不知道这水的问题怎么解决。

一般的空调制冷压缩机能耗占大头,这些风扇什么的耗电跟压缩机比起来只算零头了。

2011年4月23日 09:17 | # | 引用

mahatma 说:

水墙不能搞定灰尘吗?

2011年4月23日 09:47 | # | 引用

果子米 说:

好羡慕人家的工作环境 真想去fb工作

2011年4月23日 19:29 | # | 引用

chang 说:

福岛核电站啊,日本已经尝试过了。

2011年4月23日 22:35 | # | 引用

kevin 说:

弄错了吧,

第一道程序是喷雾冷却啊。

看图就知道了。

怎么可能是第三道。。。

那样水分太多,对机房影响不好吧

2011年4月24日 09:16 | # | 引用

yx 说:

我想知道 那个水分过多会不会 加快服务器的老化;哦

2011年4月26日 21:22 | # | 引用

tanvstan 说:

就是说这么多服务器只有100个人一班来维护?因为餐厅只有36个座位

2011年6月17日 13:47 | # | 引用

willis 说:

中国近百年不会出现如此高效的机房!

规模比它大的不少,但是其电能的利用率简直不堪!

中国的绝大多数机房都是:在绝对封闭的空间用空调降低温度。我曾经遇到过一个案子:空调失效服务器宕机,管理员去查看时,就被机房内的热浪把门冲开,把人打翻到地上,挫伤不是最严重的,而是一度烧伤。当然服务器的损失更大!!

我现在认为什么标准、什么规范在中国都是扯淡!好的机房就是:在保证防尘的情况下,让机房温度与室外温度能保持一致就是好机房!!!

2011年6月22日 00:33 | # | 引用

g3939 说:

我国正处于发展阶段,对于数据中心机房的功耗定义暂停留在以高效为主,尽量实现节能减排。所以虽然中国国力、人力资源虽都较强,但仍没有类似于此类机房的实际案例。毕竟国人做机房的短期计划仍是以高功效为主的。

中国不是不能实现此类机房,而客观条件是不具备建设此类机房的前决条件,如资金、广众的接受能力等。

所以说,中国不是不能做,是目前阶段不具备实际条件而已。

2011年7月 6日 09:32 | # | 引用

iron 说:

从示意图看,也不知道是不是官方给的示意图 ,用google 翻译了下上面的英文注解, 和本文介绍的冷却顺序不一样 ,很奇怪

2011年7月11日 18:46 | # | 引用

Ale喵 说:

有点心动。

想把我们单位的机房也改改……这需要调查……

2011年9月 3日 21:11 | # | 引用

海洋 说:

我一直在想,这么多机器,现在计算机发展速度又这么快,更新换代起来得有多少浪费啊!

2011年10月12日 20:23 | # | 引用

赵永杰 说:

2012年2月11日 03:10 | # | 引用

无名 说:

2012年9月26日 10:12 | # | 引用

hwz 说:

感觉很爽啊!

2013年8月13日 15:47 | # | 引用

thinkpad 说:

不知道百度的机房长什么样子

2014年11月 1日 11:03 | # | 引用

长江 说:

很简单的东西 做大了就给人感觉不同了

但是还是要说说作者的 物理差 空气处理的顺序都错了

外来空气 过栅栏 过水墙 过风扇墙 进机房 从房子上面出去

后来的读者也基本没发现作者的错误 呵呵~~

铜管的作用说明有很强的不和谐感,肯定有问题,不是那么个意思。

2016年6月 1日 21:42 | # | 引用